Was ist der Unterschied zwischen multispektralen und hyperspektralen Bildern?

Der Hauptunterschied zwischen multispektralen und hyperspektralen Bildern ist die Anzahl der Bänder und wie schmal die Bänder sind.

Multispektrale Bilder beziehen sich im Allgemeinen auf 3 bis 10 Bänder. Jedes Band hat einen beschreibenden Titel.

Zum Beispiel umfassen die folgenden Kanäle Rot, Grün, Blau, Nahinfrarot und kurzwelliges Infrarot.

Hyperspektrale Bilder bestehen aus viel schmaleren Bändern (10-20 nm). Ein hyperspektrales Bild kann Hunderte oder Tausende von Bändern enthalten. Im Allgemeinen haben sie keine beschreibenden Kanalnamen.

- Multispektral: 3-10 breitere Bänder.

- Hyperspektral: Hunderte von schmalen Bändern.

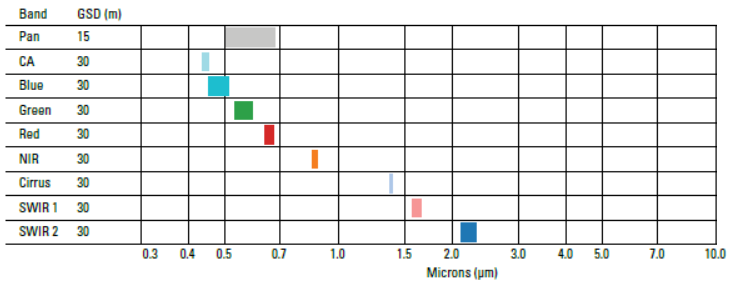

Beispiel für multispektrale Bilder

Ein Beispiel für einen multispektralen Sensor ist Landsat-8. Landsat-8 erzeugt zum Beispiel 11 Bilder mit den folgenden Bändern:

- COASTAL AEROSOL in Band 1 (0.43-0.45 um)

- BLUE in Band 2 (0.45-0.51 um)

- GREEN in Band 3 (0.53-0.59 um)

- ROT in Band 4 (0.64-0.67 um)

- NÄHER INFRAROT (NIR) in Band 5 (0.85-0.88 um)

- KURZWELLIG INFRAROT (SWIR 1) in Band 6 (1.57-1.65 um)

- SHORT-WAVE INFRARED (SWIR 2) im Band 7 (2.11-2.29 um)

- PANCHROMATIC im Band 8 (0.50-0.68 um)

- CIRRUS im Band 9 (1.36-1.38 um)

- THERMAL INFRARED (TIRS 1) im Band 10 (10.60-11.19 um)

- THERMAL INFRARED (TIRS 2) in Band 11 (11.50-12.51 um)

Jedes Band hat eine räumliche Auflösung von 30 Metern, mit Ausnahme von Band 8, 10 und 11. Während Band 8 eine räumliche Auflösung von 15 Metern hat, haben Band 10 und 11 eine Pixelgröße von 100 Metern. Da die Atmosphäre Licht in diesen Wellenlängen absorbiert, gibt es kein Band im Bereich von 0,88 bis 1,36 Metern.

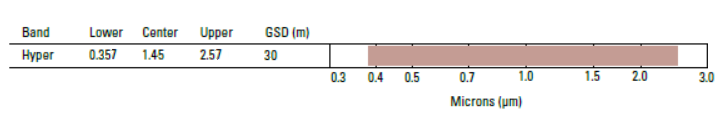

Beispiel für hyperspektrale Bilder

Im Jahr 1994 plante die NASA den ersten hyperspektralen Satelliten namens TRW Lewis. Leider verlor die NASA kurz nach dem Start den Kontakt zu ihm.

Doch später hatte die NASA einen erfolgreichen Start. Im Jahr 2000 startete die NASA den Satelliten EO-1, der den Hyperspektralsensor „Hyperion“ trug. Tatsächlich war das abbildende Spektrometer Hyperion (Teil des EO-1-Satelliten) der erste Hyperspektralsensor im Weltraum.

Hyperion erzeugt Bilder mit einer Auflösung von 30 Metern in 242 Spektralbändern (0,4-2,5 um). Wer die Hyperion-Bilder selbst ausprobieren möchte, kann die Daten auf dem USGS Earth Explorer kostenlos herunterladen.

Hyperion hat den Startschuss für die hyperspektrale Bildgebung aus dem Weltraum gegeben. Andere Hyperspektralbildgebungsmissionen aus dem Weltraum sind zum Beispiel:

- PROBA-1 (ESA) im Jahr 2001

- PRISMA (Italien) im Jahr 2019

- EnMap (Deutschland) im Jahr 2020

- HISUI (Japan) im Jahr 2020

- HyspIRI (Vereinigte Staaten) im Jahr 2024

Intuition für multispektrale und hyperspektrale

Wenn Sie diesen Beitrag lesen, sehen Ihre Augen die reflektierte Energie. Aber ein Computer sieht sie in drei Kanälen: rot, grün und blau.

- Wenn du ein Goldfisch wärst, würdest du Licht anders sehen. Ein Goldfisch kann infrarote Strahlung sehen, die für das menschliche Auge unsichtbar ist.

- Hummeln können ultraviolettes Licht sehen. Wiederum können wir Menschen ultraviolette Strahlung nicht sehen, aber UV-B schadet uns.

Stellen Sie sich nun vor, wir könnten die Welt mit den Augen eines Menschen, eines Goldfisches und einer Hummel sehen? Das können wir tatsächlich. Wir tun dies mit multispektralen und hyperspektralen Sensoren.

Das elektromagnetische Spektrum

Sichtbar (rot, grün und blau), infrarot und ultraviolett sind beschreibende Bereiche im elektromagnetischen Spektrum. Wir Menschen haben diese Bereiche zu unserem eigenen Zweck erfunden – um sie bequem zu klassifizieren. Jeder Bereich wird auf der Grundlage seiner Frequenz (v) kategorisiert.

- Menschen sehen sichtbares Licht (380 nm bis 700 nm)

- Und Goldfische sehen infrarot (700 nm bis 1mm)

- Hummeln sehen ultraviolett (10 nm bis 380 nm)

Multispektrale und hyperspektrale Bilder geben die Möglichkeit, wie Menschen zu sehen (rot, Grün und Blau), Goldfische (Infrarot) und Hummeln (Ultraviolett). Tatsächlich können wir sogar noch mehr als das sehen, da die EM-Strahlung zum Sensor reflektiert wird.

Multispektral vs. Hyperspektral

Ein höherer Grad an spektraler Detailgenauigkeit in hyperspektralen Bildern gibt eine bessere Möglichkeit, das Unsichtbare zu sehen. Beispielsweise unterscheidet die hyperspektrale Fernerkundung aufgrund ihrer hohen spektralen Auflösung zwischen 3 Mineralien. Der multispektrale Landsat Thematic Mapper konnte jedoch nicht zwischen den 3 Mineralien unterscheiden.

Einer der Nachteile ist jedoch, dass es eine zusätzliche Ebene der Komplexität gibt. Wenn man mit 200 schmalen Bändern arbeiten muss, wie kann man dann die Redundanz zwischen den Kanälen reduzieren?

Hyperspektrale und multispektrale Bilder haben viele praktische Anwendungen. Zum Beispiel verwenden wir hyperspektrale Bilder, um invasive Arten zu kartieren und bei der Exploration von Mineralien zu helfen.

Es gibt Hunderte weiterer Anwendungen, bei denen Multi- und Hyperspektralbilder uns helfen, die Welt zu verstehen. Wir nutzen sie zum Beispiel in den Bereichen Landwirtschaft, Ökologie, Öl und Gas, atmosphärische Studien und mehr.