Qual è la differenza tra immagini multispettrali e iperspettrali?

La principale differenza tra multispettrale e iperspettrale è il numero di bande e quanto sono strette le bande.

Le immagini multispettrali si riferiscono generalmente a 3 a 10 bande. Ogni banda ha un titolo descrittivo.

Per esempio, i canali sottostanti includono il rosso, il verde, il blu, il vicino infrarosso e l’infrarosso a onde corte.

Le immagini iperspettrali consistono in bande molto più strette (10-20 nm). Un’immagine iperspettrale potrebbe avere centinaia o migliaia di bande. In generale, non hanno nomi di canali descrittivi.

- Multispettrale: 3-10 bande più ampie.

- Iperspettrale: Centinaia di bande strette.

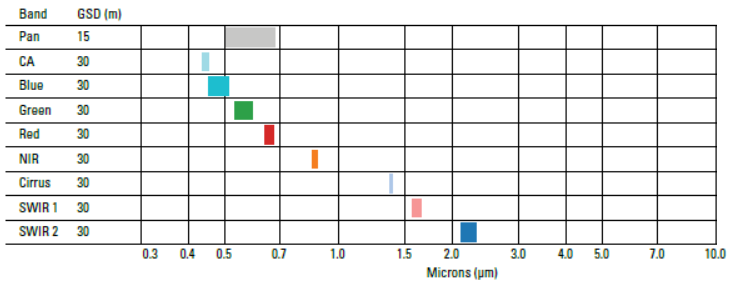

Esempio di immagini multispettrali

Un esempio di sensore multispettrale è Landsat-8. Per esempio, Landsat-8 produce 11 immagini con le seguenti bande:

- AEROSOL COSTIERO in banda 1 (0.43-0.45 um)

- BLU in banda 2 (0.45-0.51 um)

- VERDE in banda 3 (0.53-0.59 um)

- ROSSO in banda 4 (0.64-0.67 um)

- NEAR INFRARED (NIR) in banda 5 (0.85-0.88 um)

- SHORT-WAVE INFRARED (SWIR 1) in banda 6 (1.57-1.65 um)

- SHORT-WAVE INFRARED (SWIR 2) nella banda 7 (2.11-2.29 um)

- PANCHROMATIC nella banda 8 (0.50-0.68 um)

- CIRRUS nella banda 9 (1.36-1.38 um)

- THERMAL INFRARED (TIRS 1) nella banda 10 (10.60-11.19 um)

- INFRAROSSO TERMICO (TIRS 2) nella banda 11 (11.50-12.51 um)

Ogni banda ha una risoluzione spaziale di 30 metri, tranne la banda 8, 10 e 11. Mentre la banda 8 ha una risoluzione spaziale di 15 metri, le bande 10 e 11 hanno una dimensione del pixel di 100 metri. Poiché l’atmosfera assorbe le luci in queste lunghezze d’onda, non c’è nessuna banda nella gamma 0,88-1,36.

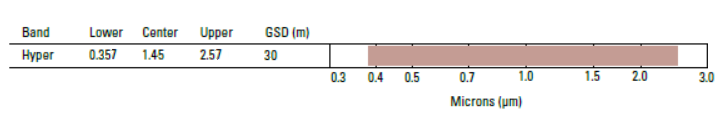

Esempio di immagini iperspettrali

Nel 1994, la NASA progettò il primo satellite iperspettrale chiamato TRW Lewis. Sfortunatamente, la NASA perse il contatto con esso poco dopo il suo lancio.

Ma in seguito la NASA ebbe una missione di lancio di successo. Nel 2000, la NASA lanciò il satellite EO-1 che portava il sensore iperspettrale “Hyperion”. Infatti, lo spettrometro di immagini Hyperion (parte del satellite EO-1) è stato il primo sensore iperspettrale dallo spazio.

Hyperion produce immagini con una risoluzione di 30 metri in 242 bande spettrali (0,4-2,5 um). Se vuoi provare tu stesso le immagini di Hyperion, puoi scaricare gratuitamente i dati su Earth Explorer dell’USGS.

Hyperion ha davvero dato il via all’inizio delle immagini iperspettrali dallo spazio. Per esempio, altre missioni di imaging iperspettrale dallo spazio includono:

- PROBA-1 (ESA) nel 2001

- PRISMA (Italia) nel 2019

- EnMap (Germania) nel 2020

- HISUI (Giappone) nel 2020

- HyspIRI (Stati Uniti) nel 2024

Istruzione per il multispettrale e iperspettrale

Quando leggi questo post, i vostri occhi vedono l’energia riflessa. Ma un computer la vede in tre canali: rosso, verde e blu.

- Se tu fossi un pesce rosso, vedresti la luce in modo diverso. Un pesce rosso può vedere la radiazione infrarossa che è invisibile all’occhio umano.

- I bombi possono vedere la luce ultravioletta. Di nuovo, gli umani non possono vedere le radiazioni ultraviolette dai nostri occhi, ma gli UV-B ci danneggiano.

Ora, immaginate se potessimo vedere il mondo con gli occhi di un umano, un pesce rosso e un bombo? In realtà, possiamo. Lo facciamo con sensori multispettrali e iperspettrali.

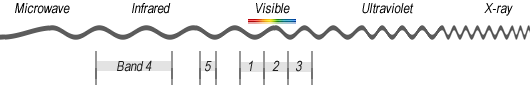

Lo spettro elettromagnetico

Visibile (rosso, verde e blu), infrarosso e ultravioletto sono regioni descrittive dello spettro elettromagnetico. Noi, gli esseri umani, abbiamo creato queste regioni per il nostro scopo – per classificarle convenientemente. Ogni regione è classificata in base alla sua frequenza (v).

- Gli esseri umani vedono la luce visibile (380 nm a 700 nm)

- E i pesci rossi vedono l’infrarosso (700 nm a 1mm)

- Le api vedono l’ultravioletto (10 nm a 380 nm)

Le immagini multispettrali e iperspettrali danno la possibilità di vedere come gli esseri umani (rosso, verde e blu), pesci rossi (infrarossi) e calabroni (ultravioletto). In realtà, possiamo vedere anche più di questo come radiazione EM riflessa al sensore.

Multispettrale vs Iperspettrale

Avere un livello superiore di dettaglio spettrale nelle immagini iperspettrali dà una migliore capacità di vedere l’invisibile. Per esempio, il telerilevamento iperspettrale distingue 3 minerali a causa della sua alta risoluzione spettrale. Ma il Landsat Thematic Mapper multispettrale non poteva distinguere tra i 3 minerali.

Ma uno degli svantaggi è che aggiunge un livello di complessità. Se hai 200 bande strette con cui lavorare, come puoi ridurre la ridondanza tra i canali?

Le immagini iperspettrali e multispettrali hanno molte applicazioni nel mondo reale. Per esempio, usiamo le immagini iperspettrali per mappare le specie invasive e aiutare nell’esplorazione mineraria.

Ci sono centinaia di altre applicazioni in cui multispettrale e iperspettrale ci permettono di capire il mondo. Per esempio, li usiamo nel campo dell’agricoltura, dell’ecologia, del petrolio e del gas, degli studi atmosferici e altro ancora.